-

- Downloads

to do list und sub-iforest implementation

Showing

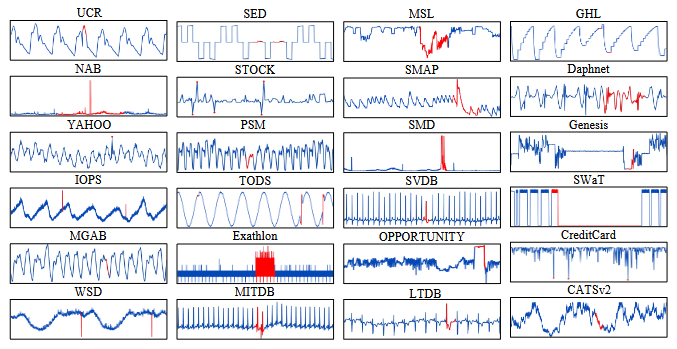

- bilder/dataset/comparing_datasets.png 0 additions, 0 deletionsbilder/dataset/comparing_datasets.png

- docs/TO DO LISTE.md 47 additions, 0 deletionsdocs/TO DO LISTE.md

- src/models/ahmad/call_KMeansAD.py 1 addition, 0 deletionssrc/models/ahmad/call_KMeansAD.py

- src/models/ahmad/call_LSTMAD.py 1 addition, 0 deletionssrc/models/ahmad/call_LSTMAD.py

- src/models/ahmad/call_PCA.py 1 addition, 0 deletionssrc/models/ahmad/call_PCA.py

- src/models/desi/call_LOF.py 1 addition, 1 deletionsrc/models/desi/call_LOF.py

- src/models/desi/call_OCSVM.py 1 addition, 1 deletionsrc/models/desi/call_OCSVM.py

- src/models/desi/call_Sub_LOF.py 1 addition, 1 deletionsrc/models/desi/call_Sub_LOF.py

- src/models/desi/call_kShapeAD.py 1 addition, 0 deletionssrc/models/desi/call_kShapeAD.py

- src/models/desi/call_omnianomaly.py 1 addition, 1 deletionsrc/models/desi/call_omnianomaly.py

- src/models/desi/call_usad.py 1 addition, 1 deletionsrc/models/desi/call_usad.py

- src/models/sofia_modelle/call_cnn.py 1 addition, 1 deletionsrc/models/sofia_modelle/call_cnn.py

- src/models/sofia_modelle/call_iforest.py 1 addition, 1 deletionsrc/models/sofia_modelle/call_iforest.py

- src/models/sofia_modelle/call_knn.py 1 addition, 1 deletionsrc/models/sofia_modelle/call_knn.py

- src/models/sofia_modelle/call_sub_iforestpy 28 additions, 0 deletionssrc/models/sofia_modelle/call_sub_iforestpy

bilder/dataset/comparing_datasets.png

0 → 100644

149 KiB

docs/TO DO LISTE.md

0 → 100644

src/models/sofia_modelle/call_sub_iforestpy

0 → 100644